Es passiert nicht oft, dass man bei einem Technikthema das Gefühl hat: Hier verändert sich gerade wirklich alles. Genau dieses Gefühl löst das Model Context Protocol (MCP) aus. Ein Standard, der es großen Sprachmodellen (LLMs) ermöglicht, Software nicht nur irgendwie anzutippen, sondern sie direkt und effizient zu bedienen.

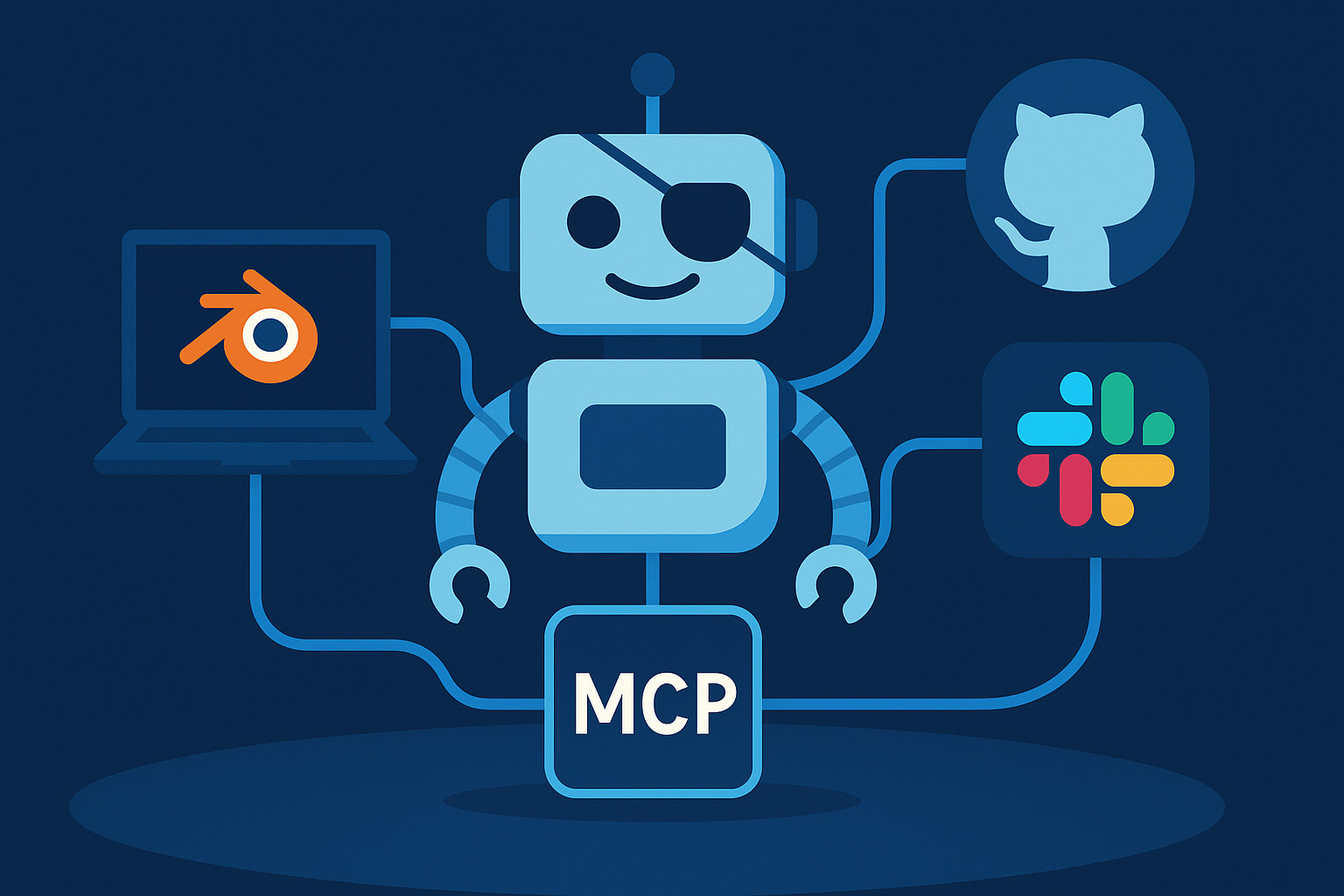

Und das ohne fummeliges API-Gebastel für jede einzelne Anwendung. Einmal implementiert, können LLMs plötzlich mit Blender, GitHub, Dropbox, Slack oder sogar eurem Dateisystem sprechen – ganz selbstverständlich, so wie USB damals das Kabel-Chaos am PC beendet hat.

Von Copy-Paste zur echten Interaktion

Bis vor Kurzem war die Interaktion mit LLMs noch sehr begrenzt:

- Texte reinkopieren, Ergebnisse wieder rausziehen.

- Erste Integrationen wie Websuche oder Canva-Anbindung – aber jedes Mal mit individuellem Anpassungsaufwand.

Mit MCP ändert sich das. Statt für jede Anwendung eine eigene Integration zu basteln, definiert MCP eine einheitliche Sprache zwischen KI und Software. Egal, ob ein Open-Source-LLM oder ein kommerzielles Modell im Hintergrund läuft – die KI versteht sofort, wie sie mit einem MCP-Server spricht.

Das Ergebnis: Sprachmodelle werden zu echten Bedienern von Softwareumgebungen. Ein Snake-Spiel programmieren, die Grafiken dafür in Blender rendern und alles in ein Video packen? Mit MCP kein Problem – auch wenn der Mensch dahinter Blender noch nie geöffnet hat.

Standardisierung wie bei USB

Die Parallele zu USB liegt auf der Hand. Früher war jede Schnittstelle proprietär – Drucker, Scanner, externe Laufwerke – nichts sprach dieselbe Sprache. Dann kam USB und plötzlich funktionierte alles miteinander.

MCP ist auf dem besten Weg, für KIs das Gleiche zu leisten. Schon jetzt gibt es über 13.000 MCPs, viele davon Testprojekte, aber auch handfeste Tools:

- Blender-MCP für 3D-Objekte, Animationen und Renderings

- Desktop-Commander-MCP für direkten Zugriff aufs Dateisystem und die Kommandozeile

- Integrationen für GitHub, Slack, Spotify, Salesforce, Datenbanken und mehr

Chancen – und Risiken

Die Chancen sind gewaltig:

- Jede Software kann theoretisch von jedem LLM bedient werden.

- Lokale Open-Source-Modelle lassen sich genauso nutzen wie Cloud-Angebote.

- Praktische Anwendungsfälle von KI rücken greifbar nahe.

Aber: Wir stehen noch am Anfang. MCP ist aktuell noch experimentell, fehleranfällig und mit einem hohen Risiko verbunden. LLMs, die ohne Nachfrage Dateien ändern, Software installieren oder Datenbanken beschreiben – das sollte man lieber in einer virtuellen Maschine testen und nicht auf dem Hauptsystem.

Fazit: Ein echter Gamechanger

MCP könnte das fehlende Puzzlestück sein, das KI von einem schlauen Assistenten zu einem universellen Bediener von Software macht.

Noch ist vieles fummelig, noch braucht es JSON-Configs und Developer-Modi – aber die Richtung ist klar: LLMs werden bald nahtlos mit unserer gesamten Softwarelandschaft interagieren können.

So wie USB die Hardware-Welt vereinheitlicht hat, könnte MCP das Fundament der KI-Interaktion werden.

Und wer einmal gesehen hat, wie eine KI Blender, GitHub und das eigene Dateisystem orchestriert, weiß: Das ist kein Hype – das ist ein Paradigmenwechsel.

👉 Wie seht ihr das? Würdet ihr MCP in euren Workflows einsetzen – oder ist euch der Gedanke, dass eine KI direkt auf euer Dateisystem zugreift, noch zu unheimlich?